先進AI視覺系統 - iToF解鎖3D立體空間的魔術師

前言

AI(Artificial intelligence)人工智慧透由ChatGPT生成式AI工具再度獲得世人的關注,但聊天機器人,是需要大量且快速的運算能力來處理複雜的人工智慧模型以及數據,而這些必須要獲得高階人工智慧(AI)晶片才能支撐的運算工作。

可是在可看見的未來,AI應用會更貼近人們的生活,它只需要一般運算力需求的AI晶片,就能達到自助與自動特定功能的工作。例如 : 只會開車的司機,送餐送貨的工人,門口的警衛,無人商店的店員,工廠的作業員及其他更多重複的工作內容。

AI也是需要視覺系統讓虛擬的AI連結到現實環境。當AI人工智慧裝上Camera攝影機,就像是人的眼睛一樣透過攝影機AI能精確的截取物體形狀、大小、顏色、深度距離的影像,甚至能傳輸到雲端,運行演算法進行分析辦識。有一句廣告詞「電腦嘛ㄟ撿土豆喔」,沒有視覺系統的AI電腦,如何撿土豆呢?可見視覺系統,在整個AI產業中,扮演極重要的角色。除了傳統的影像外AI更是需要獲得深度或距離訊息。

iToF相機

人類的眼睛可以分辨顏色,形狀與空間但是距離總是用”想像的”。這就是籃球選手距離籃框越遠命中率越低的原因。 AI的視覺中,平面(2D)與顏色可以經由一般的攝影機來達成,但距離要怎麼辦呢? 那就需要另一隻眼睛。它可以是一般的攝影機(image )或Depth感測器來協助並透過演算法得到精確的距離。

偵測距離或深度的方案 :

- 採用立體視覺(Stereo Vision)

- 結構光(structured light)的方案

- Depth感測器如下種類:光達Lidar、 iToF(Indirect Time-of- Fligh)/dToF (Direct-Time-of-Fligh) 、FMCW( Frequency Modulated Continuous Wave) ,超聲波(Ultrasound)及雷達(Radar)。

而其中iToF對於距離與空間的重現有者高度的可靠度外,還有解析度的優勢。

以下我們就原理、組成元件、距離計算方式、成像技術的應用來瞭解一下iToF感測和技術。

飛行測距(ToF:Time of Flight)原理

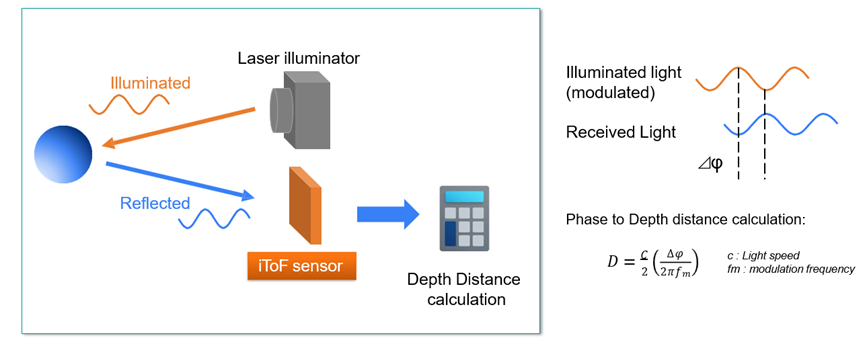

ToF相機透過測量光源發送到場景中並經由物體反射到感測元件來獲取深度資訊,若是透過發射波形和反射接收的時間差是dToF(Direct Time of FLY)而測量的是發射波形和反射接收波形之間的相位移則是iToF。參考如圖(一)

圖一

圖一

dToF和iToF在感測器原件上的區別是iToF使用CMOS工藝開發的CIS感測器(Camera Image Sensor),而dToF需要使用單光子雪崩二極管(single-photon avalanche diode,SPAD)感測器。雖然dToF有長距離與抗干擾性的特點較適用長距離的量測。而iToF在成本與空間圖像解析度的優勢很適合AI應用。

iToF感測元件

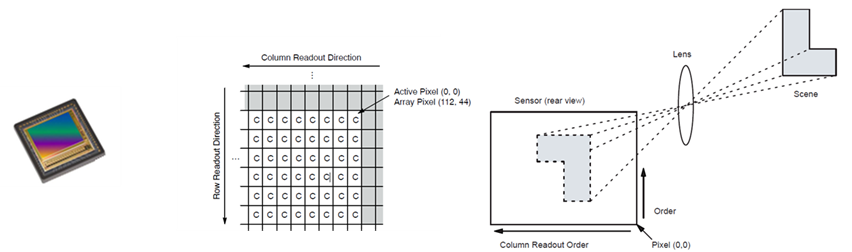

外觀與一般圖像傳感器(image sensor)無異。只是周邊的邏輯電路變更讓儲存資料內容不同如下圖(二)。

圖二 iToF感測元件/ Image Sensor(圖像傳感器外觀)

圖二 iToF感測元件/ Image Sensor(圖像傳感器外觀)

以onsemi的iToF感測元件(AF0130/AF0131)為例:

- 背照式(BSI)CMOS工藝

- 1280 X 960圖元

- Global Shutter

- 3.5 um 圖元大小

- 1/3.2 感測器大小

- AF0130 內建深度計算處理器(Depth Processing)

Image Sensor(圖像傳感器) : 連續時間內累積的能量(顏色或亮度)。

iToF depth傳感器:不同時間(frame)內量測到的反射能量(光發射後的飛行軌跡)並透過計算這些軌跡得到”光”飛行時間/距離。

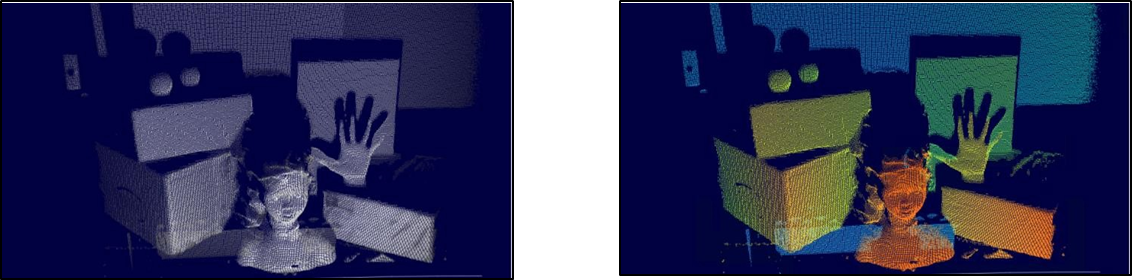

參考圖(三) Depth map

圖三 Image sensor(彩色或黑白相機)

圖三 Image sensor(彩色或黑白相機)

既然iToF Depth有計算前的能量與處理後的距離(深度)。所以除了距離的訊息外它還能以成像的方式來表現。而解度高的depth傳感器甚至可以描繪出具有細節的輪廓。參考圖(四)

圖四

圖四

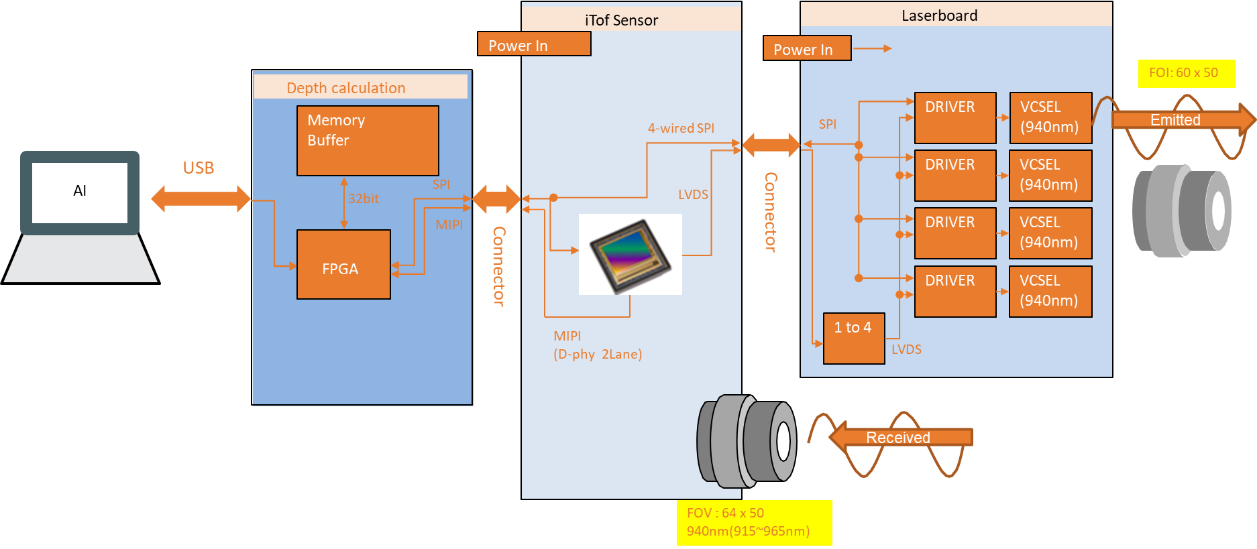

iToF核心組件與架構: 雷射驅動 / 雷射器或LED / 發射端光學 / 接收端光學 / 接收感測器CMOS / 深度計算

系統架構-圖(五) :

雷射或LED (Vertical Cavity Surface Emitting Laser :VCSE或(Edge Emitting Laser : EEL)

- 發射端光學鏡頭(Lens)

- 雷射或LED 驅動(Laser/LED Driver)

- 接收端光學鏡頭(Lens)

- 感測器CMOS iToF sensor

- 深度計算單元

圖五 iToF模方塊圖

圖五 iToF模方塊圖

目前市售的ToF應用大都選擇850nm和940nm,主要是這兩個波長的發光源器件可以使用VCSEL實現但再長的波長可能需要EEL,另一方面接收端感測器對850nm是最敏銳的,就是對該光譜的響應率最高.可以得到最佳的信噪比,940nm的感度會比850nm低,但對人眼的干擾較低。

如果波長要更長,感測器的製造會更難,在電子消費品中很少選擇.可是在眼球保護(Eyesafe)法規下或許不久就會其他發光源器件與iToF sensor問世。

感測與計算

幀率( frame rate) 是每秒可以更新距離訊息次數,所以對於移動的物體iToF 感測器具有高幀率與計算單元可以減小物體移動時間誤差。一般認定每秒超過60 幀(frame)為高幀率。

另外由於計算單元需要不斷計算即時相位偏移資訊來獲得當下的探測距離,若iToF 感測器沒有內建Depth Mapping 處理器與記憶儲存空間那資料就需要傳送所有的相位差資料到計算單元,這樣就延遲了距離偵測的時效性,所以感測與計算在同一元件是最佳的方式。

iTof探測距離

indirect time of flight,非直接測量TOF,方法是測量發射端的正弦波或脈衝信號與接收端的正弦波或脈衝信號的相位差的透過演算法計算出時間,也稱為phase-based ToF。在iToF系統中,相位差的函數是測量光強度而不是時間,這是iToF的硬體使用普通的圖像感測器架構的緣由,圖像感測器的特點就是在一個固定時間收集光子,然後轉化成電信號輸出。

iTof感測器輸出的是接收到的光強還有計數後的時間函數,通過對比函數與光強,計算出飛行時間。

iToF可以按發射光波的方式分成連續波調製(CW-iToF)和脈衝調製(Pulsed-iToF)。

連續波(CW)調變與調頻連續波(FMCW)

連續波iToF的基本原理是將光調製為固定或多個頻率f的正弦波,發射端依照頻率f發射正弦波,當採集返回的光能量時,連續波iToF會根據不同的相位打開多個視窗(frame),對多個視窗相位的資料進行採樣,分析該時期內發射和接收的相位差資訊,然後通過公式得到距離資訊。需要注意的是距離偵測(Depth)精度與頻率f成正比,可檢測最大距離與頻率f成反比。

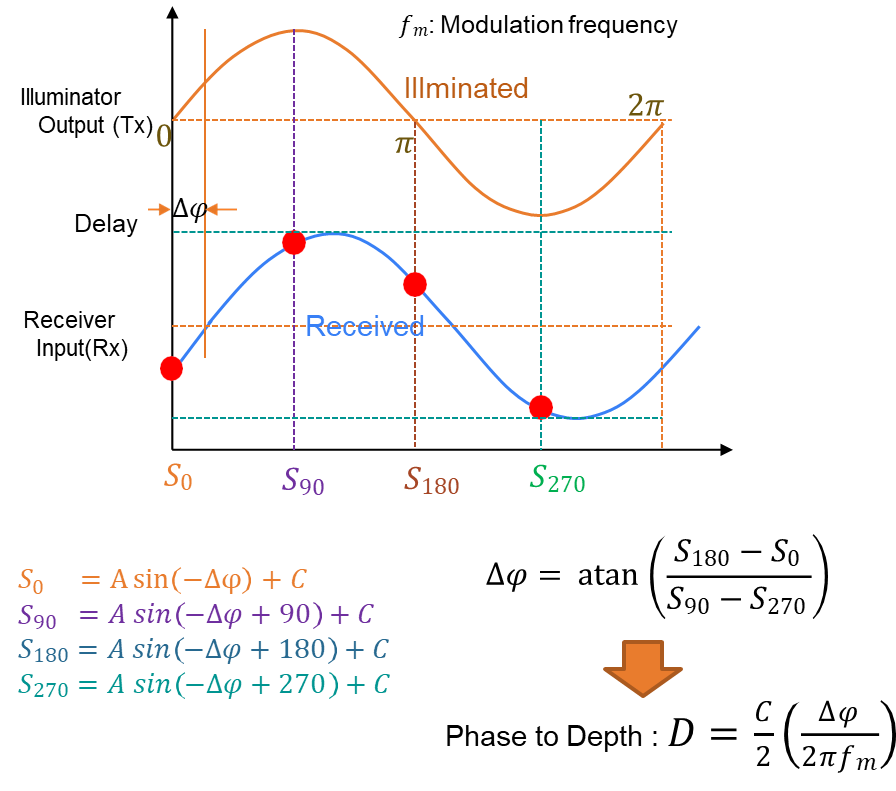

iToF 4個相位差資料測量:

iToF是針對相位差資料來計算距離,相位分別是 0 ゚,90 ゚, 180゚,270 ゚。

但是誤差存在於每個系統因此depth計算每次大概需要是4~8 frame的4個相位資料來確認相位偏移正確性。參考如下圖(六)

圖六 連續波(CW)調變相位差資料與計算

圖六 連續波(CW)調變相位差資料與計算

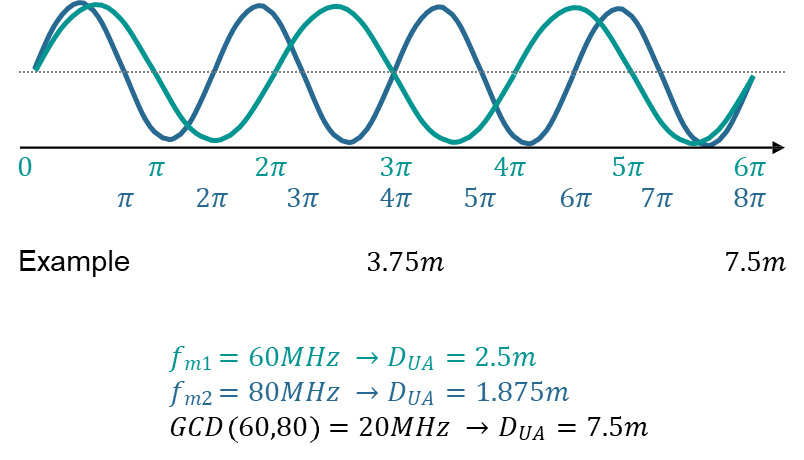

iToF 雙頻測量 :

透過發射兩個頻率的光譜得到的相位差資料與計算用於長距離消除相位模糊

圖七 雙頻測量

圖七 雙頻測量

若是調頻連續波(FMCW)方法為基礎的LiDAR感測器,可提供深度,速度和極化強度的資料。而FMCW是被廣泛應用於都普勒(coherent Doppler)架構為基礎的技術;FMWC持續發射脈衝弦波,在訊號返回時計算發射和接收端的相位差。由於都普勒效應,該偏移是偵測物體距離和速度的函數。

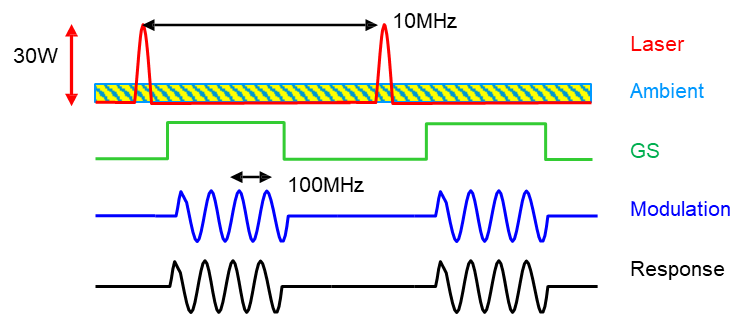

脈衝式iToF

由於多個調製頻率下進行四次相關函數採樣。對於較長距離的測量,或場景中環境光較強時,對連續輸出功率要求較高,會影響加熱和穩定性。

而功率高對人眼安全相關法規也是不利的。因此可透由改變發射脈衝模式或選擇更長奈米波長的光(>950奈米波長),來達到更長距離的目標偵測.

例如: 功率提高到30W但調製頻率由100Mhz 降為10Mhz,圖(八)。

圖八 脈衝式iToF調變與功率示意圖

圖八 脈衝式iToF調變與功率示意圖

iToF相機應用: 「3D/4D」的空間地圖與物件識別

從現實與虛擬的AR/VR到人臉或手勢辨識 AI可以認知將為某人提供適合的服務。AI自主移動機器或機器手臂可以知道在倉庫移動與搬運對的物品,甚至可以應用在汽車的自動駕駛與安全輔助。

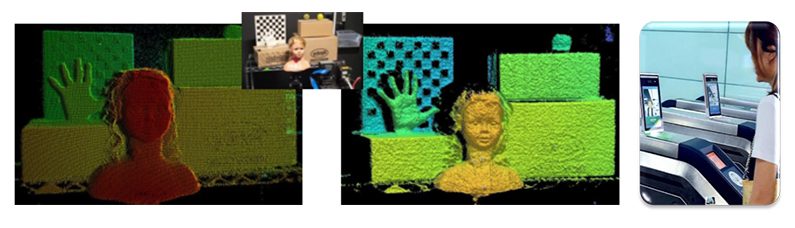

圖九

圖九

iToF相機優勢

- 內建Depth Mapping處理器與記憶模組(Memory)。

- 百萬像素(Mage)等級的圖元解析度。

- 低動態拖影(Low Motion Artifacts) & 高幀率(Hight frame)。

- 長景深距離與高環境光抑制。

- 短距離與人眼保護 - 奈米波長與頻率響應(Quantum Efficiency)。

機器視覺的方案透由各種的感測器搭配且要有快速及高更新率來維持即時且準確的空間地圖。然後以AI為基礎的智能產品才能透過最精確的訊息以達成任務。

所以綜合以上iToF相機的優勢是實現「3D/4D」的AI視覺-空間地圖與定位的最佳方案。

運動偽影

當要辨別運動的物體或手勢往往是一個瞬間發生的動作若相機沒有高效率與高幀率(Hight frame) 常常會造成拖影或辨識錯誤,像機器手臂或自主移動機器人就需要高效率與高幀率的特性。

圖十 運動偽影及應用

圖十 運動偽影及應用

百萬像素(Mage pixel)的圖元解析度

而百萬像素等級的圖元解析度如同讓人一眼就看出真假與辨識出特徵,就尤其在人臉

的識別上是不可或缺的特點。

圖十一 百萬像素(Mage)等級的圖元解析度及應用

圖十一 百萬像素(Mage)等級的圖元解析度及應用

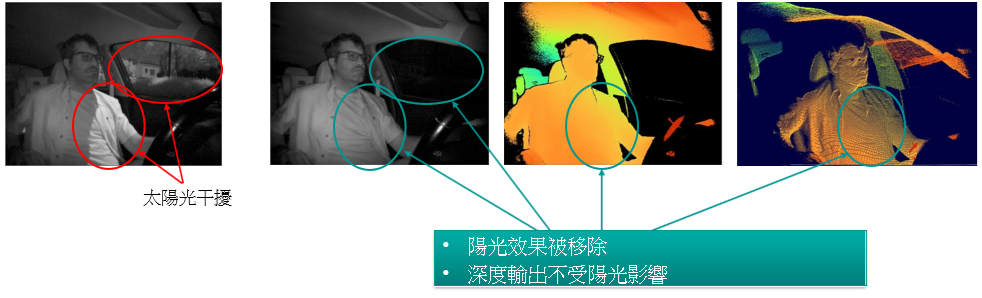

不受人工或自然的光源干擾

COMS Sensor具有高量子效率(Quantum Efficiency , QE)能對入射光子400~1100nm波長的光譜能量能更有效率轉換成電子的訊號。這就是先前提到為何光源可以選擇850nm~940nm波長的不可見光,並透過控制雷射或LED驅動讓偵測做彈性的變化且搭配波長的不可見光不管室內室外都不會被人工或自然的光源所干擾。

圖十二 不受人工或自然的光源所干擾

圖十二 不受人工或自然的光源所干擾

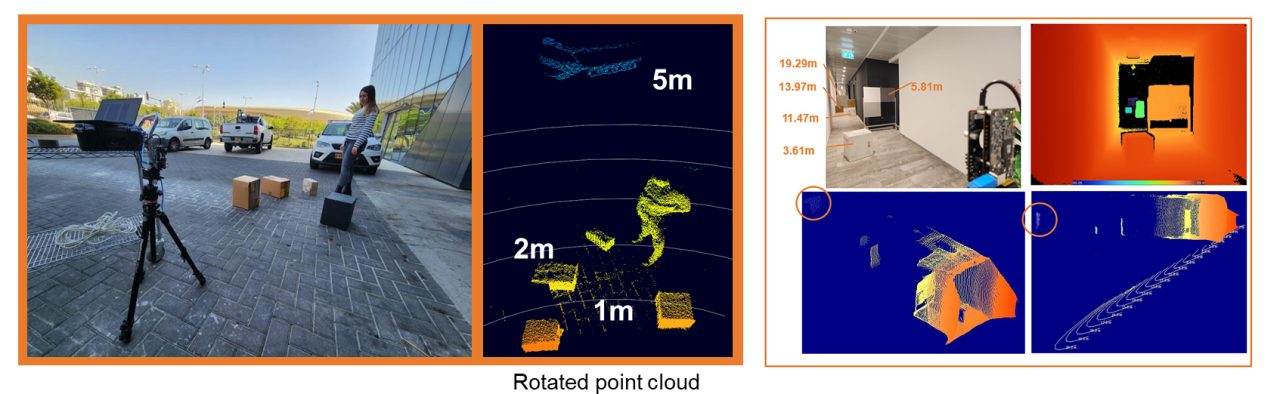

長短距離偵測:

- 短距離 : 發出能量低的光譜搭配較高的頻率以提高精確度。

- 長距離 : 提高雷射或LED能量但搭配較低頻率,除了延長有效測距的範圍外還可以抑制發射端功耗降低散熱問題。

圖十三 短距精度及應用

圖十三 短距精度及應用

圖十四 長度離延伸及室內室外的應用

圖十四 長度離延伸及室內室外的應用

結論

ToF應用非常多,電子消費領域有人臉識別,照相機輔助對焦,接近感測器,體感互動,手勢識別,AR,機器人/無人機避障與3D/4D場景掃描等等;工業和安防應用可以用於工業自動化機器人,人數統計,智能停車場,智能交通,自動化倉儲管理,電子圍籬及距離測量等;汽車領域則可以用於智慧駕駛輔助,哨兵模式或自動停車。

若是導入以AI為基礎演算法上述應用則會進一步智能化,AI能根據視覺系統反饋的訊息重現空間並進行物件識別,除了距離(depth)外 AI 還可以經由幀( frame)與幀( frame)的訊息差異進行移動物體的速度計算.因為AI可以確切瞭解目標物並控制自身的行動速度及高精確度。如此可以推算正確的指令.

未來AI更會搭配ToF與影像系統深入各種消費,資訊安全,工業自動化,自主機器人與汽車安全的應用讓每個產品都像個可靠的AI機器人,這需要高解析深度成像技術的iToF與影像視覺系統的空間與定位來給與達成決各種任務的眼睛。

隨著應用提升CPU任務繁重可想而知,從單純的距離感知到自主行動最終達到AI互動的能力.因此就近感測器進行資料處理的必要性;如果可能,應該所有預處理、清理和AI強化都必要在感測器的位置進行,以減輕CPU的負擔.就像人類的神經反應一樣不需要每個動作都要經過大腦思考.目前已有直接距離計算的能力的產品所以對於距離事實上可以直接反應只是”運算”能力如何附加與克服附加之後的散熱問題。

參考文獻

- Onsemi 官方網站(https://www.onsemi.com/)及文件

- Google (https://www.google.com/)

- 維基百科(https://zh.wikipedia.org/)